$

\newcommand{\undefined}{}

\newcommand{\hfill}{}

\newcommand{\qedhere}{\square}

\newcommand{\qed}{\square}

\newcommand{\ensuremath}[1]{#1}

\newcommand{\bit}{\{0,1\}}

\newcommand{\Bit}{\{-1,1\}}

\newcommand{\Stab}{\mathbf{Stab}}

\newcommand{\NS}{\mathbf{NS}}

\newcommand{\ba}{\mathbf{a}}

\newcommand{\bc}{\mathbf{c}}

\newcommand{\bd}{\mathbf{d}}

\newcommand{\be}{\mathbf{e}}

\newcommand{\bh}{\mathbf{h}}

\newcommand{\br}{\mathbf{r}}

\newcommand{\bs}{\mathbf{s}}

\newcommand{\bx}{\mathbf{x}}

\newcommand{\by}{\mathbf{y}}

\newcommand{\bz}{\mathbf{z}}

\newcommand{\Var}{\mathbf{Var}}

\newcommand{\dist}{\text{dist}}

\newcommand{\norm}[1]{\\|#1\\|}

\newcommand{\etal}

\newcommand{\ie}

\newcommand{\eg}

\newcommand{\cf}

\newcommand{\rank}{\text{rank}}

\newcommand{\tr}{\text{tr}}

\newcommand{\mor}{\text{Mor}}

\newcommand{\hom}{\text{Hom}}

\newcommand{\id}{\text{id}}

\newcommand{\obj}{\text{obj}}

\newcommand{\pr}{\text{pr}}

\newcommand{\ker}{\text{ker}}

\newcommand{\coker}{\text{coker}}

\newcommand{\im}{\text{im}}

\newcommand{\vol}{\text{vol}}

\newcommand{\disc}{\text{disc}}

\newcommand{\bbA}{\mathbb A}

\newcommand{\bbB}{\mathbb B}

\newcommand{\bbC}{\mathbb C}

\newcommand{\bbD}{\mathbb D}

\newcommand{\bbE}{\mathbb E}

\newcommand{\bbF}{\mathbb F}

\newcommand{\bbG}{\mathbb G}

\newcommand{\bbH}{\mathbb H}

\newcommand{\bbI}{\mathbb I}

\newcommand{\bbJ}{\mathbb J}

\newcommand{\bbK}{\mathbb K}

\newcommand{\bbL}{\mathbb L}

\newcommand{\bbM}{\mathbb M}

\newcommand{\bbN}{\mathbb N}

\newcommand{\bbO}{\mathbb O}

\newcommand{\bbP}{\mathbb P}

\newcommand{\bbQ}{\mathbb Q}

\newcommand{\bbR}{\mathbb R}

\newcommand{\bbS}{\mathbb S}

\newcommand{\bbT}{\mathbb T}

\newcommand{\bbU}{\mathbb U}

\newcommand{\bbV}{\mathbb V}

\newcommand{\bbW}{\mathbb W}

\newcommand{\bbX}{\mathbb X}

\newcommand{\bbY}{\mathbb Y}

\newcommand{\bbZ}{\mathbb Z}

\newcommand{\sA}{\mathscr A}

\newcommand{\sB}{\mathscr B}

\newcommand{\sC}{\mathscr C}

\newcommand{\sD}{\mathscr D}

\newcommand{\sE}{\mathscr E}

\newcommand{\sF}{\mathscr F}

\newcommand{\sG}{\mathscr G}

\newcommand{\sH}{\mathscr H}

\newcommand{\sI}{\mathscr I}

\newcommand{\sJ}{\mathscr J}

\newcommand{\sK}{\mathscr K}

\newcommand{\sL}{\mathscr L}

\newcommand{\sM}{\mathscr M}

\newcommand{\sN}{\mathscr N}

\newcommand{\sO}{\mathscr O}

\newcommand{\sP}{\mathscr P}

\newcommand{\sQ}{\mathscr Q}

\newcommand{\sR}{\mathscr R}

\newcommand{\sS}{\mathscr S}

\newcommand{\sT}{\mathscr T}

\newcommand{\sU}{\mathscr U}

\newcommand{\sV}{\mathscr V}

\newcommand{\sW}{\mathscr W}

\newcommand{\sX}{\mathscr X}

\newcommand{\sY}{\mathscr Y}

\newcommand{\sZ}{\mathscr Z}

\newcommand{\sfA}{\mathsf A}

\newcommand{\sfB}{\mathsf B}

\newcommand{\sfC}{\mathsf C}

\newcommand{\sfD}{\mathsf D}

\newcommand{\sfE}{\mathsf E}

\newcommand{\sfF}{\mathsf F}

\newcommand{\sfG}{\mathsf G}

\newcommand{\sfH}{\mathsf H}

\newcommand{\sfI}{\mathsf I}

\newcommand{\sfJ}{\mathsf J}

\newcommand{\sfK}{\mathsf K}

\newcommand{\sfL}{\mathsf L}

\newcommand{\sfM}{\mathsf M}

\newcommand{\sfN}{\mathsf N}

\newcommand{\sfO}{\mathsf O}

\newcommand{\sfP}{\mathsf P}

\newcommand{\sfQ}{\mathsf Q}

\newcommand{\sfR}{\mathsf R}

\newcommand{\sfS}{\mathsf S}

\newcommand{\sfT}{\mathsf T}

\newcommand{\sfU}{\mathsf U}

\newcommand{\sfV}{\mathsf V}

\newcommand{\sfW}{\mathsf W}

\newcommand{\sfX}{\mathsf X}

\newcommand{\sfY}{\mathsf Y}

\newcommand{\sfZ}{\mathsf Z}

\newcommand{\cA}{\mathcal A}

\newcommand{\cB}{\mathcal B}

\newcommand{\cC}{\mathcal C}

\newcommand{\cD}{\mathcal D}

\newcommand{\cE}{\mathcal E}

\newcommand{\cF}{\mathcal F}

\newcommand{\cG}{\mathcal G}

\newcommand{\cH}{\mathcal H}

\newcommand{\cI}{\mathcal I}

\newcommand{\cJ}{\mathcal J}

\newcommand{\cK}{\mathcal K}

\newcommand{\cL}{\mathcal L}

\newcommand{\cM}{\mathcal M}

\newcommand{\cN}{\mathcal N}

\newcommand{\cO}{\mathcal O}

\newcommand{\cP}{\mathcal P}

\newcommand{\cQ}{\mathcal Q}

\newcommand{\cR}{\mathcal R}

\newcommand{\cS}{\mathcal S}

\newcommand{\cT}{\mathcal T}

\newcommand{\cU}{\mathcal U}

\newcommand{\cV}{\mathcal V}

\newcommand{\cW}{\mathcal W}

\newcommand{\cX}{\mathcal X}

\newcommand{\cY}{\mathcal Y}

\newcommand{\cZ}{\mathcal Z}

\newcommand{\bfA}{\mathbf A}

\newcommand{\bfB}{\mathbf B}

\newcommand{\bfC}{\mathbf C}

\newcommand{\bfD}{\mathbf D}

\newcommand{\bfE}{\mathbf E}

\newcommand{\bfF}{\mathbf F}

\newcommand{\bfG}{\mathbf G}

\newcommand{\bfH}{\mathbf H}

\newcommand{\bfI}{\mathbf I}

\newcommand{\bfJ}{\mathbf J}

\newcommand{\bfK}{\mathbf K}

\newcommand{\bfL}{\mathbf L}

\newcommand{\bfM}{\mathbf M}

\newcommand{\bfN}{\mathbf N}

\newcommand{\bfO}{\mathbf O}

\newcommand{\bfP}{\mathbf P}

\newcommand{\bfQ}{\mathbf Q}

\newcommand{\bfR}{\mathbf R}

\newcommand{\bfS}{\mathbf S}

\newcommand{\bfT}{\mathbf T}

\newcommand{\bfU}{\mathbf U}

\newcommand{\bfV}{\mathbf V}

\newcommand{\bfW}{\mathbf W}

\newcommand{\bfX}{\mathbf X}

\newcommand{\bfY}{\mathbf Y}

\newcommand{\bfZ}{\mathbf Z}

\newcommand{\rmA}{\mathrm A}

\newcommand{\rmB}{\mathrm B}

\newcommand{\rmC}{\mathrm C}

\newcommand{\rmD}{\mathrm D}

\newcommand{\rmE}{\mathrm E}

\newcommand{\rmF}{\mathrm F}

\newcommand{\rmG}{\mathrm G}

\newcommand{\rmH}{\mathrm H}

\newcommand{\rmI}{\mathrm I}

\newcommand{\rmJ}{\mathrm J}

\newcommand{\rmK}{\mathrm K}

\newcommand{\rmL}{\mathrm L}

\newcommand{\rmM}{\mathrm M}

\newcommand{\rmN}{\mathrm N}

\newcommand{\rmO}{\mathrm O}

\newcommand{\rmP}{\mathrm P}

\newcommand{\rmQ}{\mathrm Q}

\newcommand{\rmR}{\mathrm R}

\newcommand{\rmS}{\mathrm S}

\newcommand{\rmT}{\mathrm T}

\newcommand{\rmU}{\mathrm U}

\newcommand{\rmV}{\mathrm V}

\newcommand{\rmW}{\mathrm W}

\newcommand{\rmX}{\mathrm X}

\newcommand{\rmY}{\mathrm Y}

\newcommand{\rmZ}{\mathrm Z}

\newcommand{\bb}{\mathbf{b}}

\newcommand{\bv}{\mathbf{v}}

\newcommand{\bw}{\mathbf{w}}

\newcommand{\bx}{\mathbf{x}}

\newcommand{\by}{\mathbf{y}}

\newcommand{\bz}{\mathbf{z}}

\newcommand{\paren}[1]{( #1 )}

\newcommand{\Paren}[1]{\left( #1 \right)}

\newcommand{\bigparen}[1]{\bigl( #1 \bigr)}

\newcommand{\Bigparen}[1]{\Bigl( #1 \Bigr)}

\newcommand{\biggparen}[1]{\biggl( #1 \biggr)}

\newcommand{\Biggparen}[1]{\Biggl( #1 \Biggr)}

\newcommand{\abs}[1]{\lvert #1 \rvert}

\newcommand{\Abs}[1]{\left\lvert #1 \right\rvert}

\newcommand{\bigabs}[1]{\bigl\lvert #1 \bigr\rvert}

\newcommand{\Bigabs}[1]{\Bigl\lvert #1 \Bigr\rvert}

\newcommand{\biggabs}[1]{\biggl\lvert #1 \biggr\rvert}

\newcommand{\Biggabs}[1]{\Biggl\lvert #1 \Biggr\rvert}

\newcommand{\card}[1]{\left| #1 \right|}

\newcommand{\Card}[1]{\left\lvert #1 \right\rvert}

\newcommand{\bigcard}[1]{\bigl\lvert #1 \bigr\rvert}

\newcommand{\Bigcard}[1]{\Bigl\lvert #1 \Bigr\rvert}

\newcommand{\biggcard}[1]{\biggl\lvert #1 \biggr\rvert}

\newcommand{\Biggcard}[1]{\Biggl\lvert #1 \Biggr\rvert}

\newcommand{\norm}[1]{\lVert #1 \rVert}

\newcommand{\Norm}[1]{\left\lVert #1 \right\rVert}

\newcommand{\bignorm}[1]{\bigl\lVert #1 \bigr\rVert}

\newcommand{\Bignorm}[1]{\Bigl\lVert #1 \Bigr\rVert}

\newcommand{\biggnorm}[1]{\biggl\lVert #1 \biggr\rVert}

\newcommand{\Biggnorm}[1]{\Biggl\lVert #1 \Biggr\rVert}

\newcommand{\iprod}[1]{\langle #1 \rangle}

\newcommand{\Iprod}[1]{\left\langle #1 \right\rangle}

\newcommand{\bigiprod}[1]{\bigl\langle #1 \bigr\rangle}

\newcommand{\Bigiprod}[1]{\Bigl\langle #1 \Bigr\rangle}

\newcommand{\biggiprod}[1]{\biggl\langle #1 \biggr\rangle}

\newcommand{\Biggiprod}[1]{\Biggl\langle #1 \Biggr\rangle}

\newcommand{\set}[1]{\lbrace #1 \rbrace}

\newcommand{\Set}[1]{\left\lbrace #1 \right\rbrace}

\newcommand{\bigset}[1]{\bigl\lbrace #1 \bigr\rbrace}

\newcommand{\Bigset}[1]{\Bigl\lbrace #1 \Bigr\rbrace}

\newcommand{\biggset}[1]{\biggl\lbrace #1 \biggr\rbrace}

\newcommand{\Biggset}[1]{\Biggl\lbrace #1 \Biggr\rbrace}

\newcommand{\bracket}[1]{\lbrack #1 \rbrack}

\newcommand{\Bracket}[1]{\left\lbrack #1 \right\rbrack}

\newcommand{\bigbracket}[1]{\bigl\lbrack #1 \bigr\rbrack}

\newcommand{\Bigbracket}[1]{\Bigl\lbrack #1 \Bigr\rbrack}

\newcommand{\biggbracket}[1]{\biggl\lbrack #1 \biggr\rbrack}

\newcommand{\Biggbracket}[1]{\Biggl\lbrack #1 \Biggr\rbrack}

\newcommand{\ucorner}[1]{\ulcorner #1 \urcorner}

\newcommand{\Ucorner}[1]{\left\ulcorner #1 \right\urcorner}

\newcommand{\bigucorner}[1]{\bigl\ulcorner #1 \bigr\urcorner}

\newcommand{\Bigucorner}[1]{\Bigl\ulcorner #1 \Bigr\urcorner}

\newcommand{\biggucorner}[1]{\biggl\ulcorner #1 \biggr\urcorner}

\newcommand{\Biggucorner}[1]{\Biggl\ulcorner #1 \Biggr\urcorner}

\newcommand{\ceil}[1]{\lceil #1 \rceil}

\newcommand{\Ceil}[1]{\left\lceil #1 \right\rceil}

\newcommand{\bigceil}[1]{\bigl\lceil #1 \bigr\rceil}

\newcommand{\Bigceil}[1]{\Bigl\lceil #1 \Bigr\rceil}

\newcommand{\biggceil}[1]{\biggl\lceil #1 \biggr\rceil}

\newcommand{\Biggceil}[1]{\Biggl\lceil #1 \Biggr\rceil}

\newcommand{\floor}[1]{\lfloor #1 \rfloor}

\newcommand{\Floor}[1]{\left\lfloor #1 \right\rfloor}

\newcommand{\bigfloor}[1]{\bigl\lfloor #1 \bigr\rfloor}

\newcommand{\Bigfloor}[1]{\Bigl\lfloor #1 \Bigr\rfloor}

\newcommand{\biggfloor}[1]{\biggl\lfloor #1 \biggr\rfloor}

\newcommand{\Biggfloor}[1]{\Biggl\lfloor #1 \Biggr\rfloor}

\newcommand{\lcorner}[1]{\llcorner #1 \lrcorner}

\newcommand{\Lcorner}[1]{\left\llcorner #1 \right\lrcorner}

\newcommand{\biglcorner}[1]{\bigl\llcorner #1 \bigr\lrcorner}

\newcommand{\Biglcorner}[1]{\Bigl\llcorner #1 \Bigr\lrcorner}

\newcommand{\bigglcorner}[1]{\biggl\llcorner #1 \biggr\lrcorner}

\newcommand{\Bigglcorner}[1]{\Biggl\llcorner #1 \Biggr\lrcorner}

\newcommand{\ket}[1]{| #1 \rangle}

\newcommand{\bra}[1]{\langle #1 |}

\newcommand{\braket}[2]{\langle #1 | #2 \rangle}

\newcommand{\ketbra}[1]{| #1 \rangle\langle #1 |}

\newcommand{\e}{\varepsilon}

\newcommand{\eps}{\varepsilon}

\newcommand{\from}{\colon}

\newcommand{\super}[2]{#1^{(#2)}}

\newcommand{\varsuper}[2]{#1^{\scriptscriptstyle (#2)}}

\newcommand{\tensor}{\otimes}

\newcommand{\eset}{\emptyset}

\newcommand{\sse}{\subseteq}

\newcommand{\sst}{\substack}

\newcommand{\ot}{\otimes}

\newcommand{\Esst}[1]{\bbE_{\substack{#1}}}

\newcommand{\vbig}{\vphantom{\bigoplus}}

\newcommand{\seteq}{\mathrel{\mathop:}=}

\newcommand{\defeq}{\stackrel{\mathrm{def}}=}

\newcommand{\Mid}{\mathrel{}\middle|\mathrel{}}

\newcommand{\Ind}{\mathbf 1}

\newcommand{\bits}{\{0,1\}}

\newcommand{\sbits}{\{\pm 1\}}

\newcommand{\R}{\mathbb R}

\newcommand{\Rnn}{\R_{\ge 0}}

\newcommand{\N}{\mathbb N}

\newcommand{\Z}{\mathbb Z}

\newcommand{\Q}{\mathbb Q}

\newcommand{\C}{\mathbb C}

\newcommand{\A}{\mathbb A}

\newcommand{\Real}{\mathbb R}

\newcommand{\mper}{\,.}

\newcommand{\mcom}{\,,}

\DeclareMathOperator{\Id}{Id}

\DeclareMathOperator{\cone}{cone}

\DeclareMathOperator{\vol}{vol}

\DeclareMathOperator{\val}{val}

\DeclareMathOperator{\opt}{opt}

\DeclareMathOperator{\Opt}{Opt}

\DeclareMathOperator{\Val}{Val}

\DeclareMathOperator{\LP}{LP}

\DeclareMathOperator{\SDP}{SDP}

\DeclareMathOperator{\Tr}{Tr}

\DeclareMathOperator{\Inf}{Inf}

\DeclareMathOperator{\size}{size}

\DeclareMathOperator{\poly}{poly}

\DeclareMathOperator{\polylog}{polylog}

\DeclareMathOperator{\min}{min}

\DeclareMathOperator{\max}{max}

\DeclareMathOperator{\argmax}{arg\,max}

\DeclareMathOperator{\argmin}{arg\,min}

\DeclareMathOperator{\qpoly}{qpoly}

\DeclareMathOperator{\qqpoly}{qqpoly}

\DeclareMathOperator{\conv}{conv}

\DeclareMathOperator{\Conv}{Conv}

\DeclareMathOperator{\supp}{supp}

\DeclareMathOperator{\sign}{sign}

\DeclareMathOperator{\perm}{perm}

\DeclareMathOperator{\mspan}{span}

\DeclareMathOperator{\mrank}{rank}

\DeclareMathOperator{\E}{\mathbb E}

\DeclareMathOperator{\pE}{\tilde{\mathbb E}}

\DeclareMathOperator{\Pr}{\mathbb P}

\DeclareMathOperator{\Span}{Span}

\DeclareMathOperator{\Cone}{Cone}

\DeclareMathOperator{\junta}{junta}

\DeclareMathOperator{\NSS}{NSS}

\DeclareMathOperator{\SA}{SA}

\DeclareMathOperator{\SOS}{SOS}

\DeclareMathOperator{\Stab}{\mathbf Stab}

\DeclareMathOperator{\Det}{\textbf{Det}}

\DeclareMathOperator{\Perm}{\textbf{Perm}}

\DeclareMathOperator{\Sym}{\textbf{Sym}}

\DeclareMathOperator{\Pow}{\textbf{Pow}}

\DeclareMathOperator{\Gal}{\textbf{Gal}}

\DeclareMathOperator{\Aut}{\textbf{Aut}}

\newcommand{\iprod}[1]{\langle #1 \rangle}

\newcommand{\cE}{\mathcal{E}}

\newcommand{\E}{\mathbb{E}}

\newcommand{\pE}{\tilde{\mathbb{E}}}

\newcommand{\N}{\mathbb{N}}

\renewcommand{\P}{\mathcal{P}}

\notag

$

$

\newcommand{\sleq}{\ensuremath{\preceq}}

\newcommand{\sgeq}{\ensuremath{\succeq}}

\newcommand{\diag}{\ensuremath{\mathrm{diag}}}

\newcommand{\support}{\ensuremath{\mathrm{support}}}

\newcommand{\zo}{\ensuremath{\{0,1\}}}

\newcommand{\pmo}{\ensuremath{\{\pm 1\}}}

\newcommand{\uppersos}{\ensuremath{\overline{\mathrm{sos}}}}

\newcommand{\lambdamax}{\ensuremath{\lambda_{\mathrm{max}}}}

\newcommand{\rank}{\ensuremath{\mathrm{rank}}}

\newcommand{\Mslow}{\ensuremath{M_{\mathrm{slow}}}}

\newcommand{\Mfast}{\ensuremath{M_{\mathrm{fast}}}}

\newcommand{\Mdiag}{\ensuremath{M_{\mathrm{diag}}}}

\newcommand{\Mcross}{\ensuremath{M_{\mathrm{cross}}}}

\newcommand{\eqdef}{\ensuremath{ =^{def}}}

\newcommand{\threshold}{\ensuremath{\mathrm{threshold}}}

\newcommand{\vbls}{\ensuremath{\mathrm{vbls}}}

\newcommand{\cons}{\ensuremath{\mathrm{cons}}}

\newcommand{\edges}{\ensuremath{\mathrm{edges}}}

\newcommand{\cl}{\ensuremath{\mathrm{cl}}}

\newcommand{\xor}{\ensuremath{\oplus}}

\newcommand{\1}{\ensuremath{\mathrm{1}}}

\notag

$

$

\newcommand{\transpose}[1]{\ensuremath{#1{}^{\mkern-2mu\intercal}}}

\newcommand{\dyad}[1]{\ensuremath{#1#1{}^{\mkern-2mu\intercal}}}

\newcommand{\nchoose}[1]{\ensuremath}

\newcommand{\generated}[1]{\ensuremath{\langle #1 \rangle}}

\notag

$

$

\newcommand{\eqdef}{\mathbin{\stackrel{\rm def}{=}}}

\newcommand{\R} % real numbers

\newcommand{\N}} % natural numbers

\newcommand{\Z} % integers

\newcommand{\F} % a field

\newcommand{\Q} % the rationals

\newcommand{\C}{\mathbb{C}} % the complexes

\newcommand{\poly}}

\newcommand{\polylog}}

\newcommand{\loglog}}}

\newcommand{\zo}{\{0,1\}}

\newcommand{\suchthat}

\newcommand{\pr}[1]{\Pr\left[#1\right]}

\newcommand{\deffont}{\em}

\newcommand{\getsr}{\mathbin{\stackrel{\mbox{\tiny R}}{\gets}}}

\newcommand{\Exp}{\mathop{\mathrm E}\displaylimits} % expectation

\newcommand{\Var}{\mathop{\mathrm Var}\displaylimits} % variance

\newcommand{\xor}{\oplus}

\newcommand{\GF}{\mathrm{GF}}

\newcommand{\eps}{\varepsilon}

\notag

$

$

\newcommand{\class}[1]{\mathbf{#1}}

\newcommand{\coclass}[1]{\mathbf{co\mbox{-}#1}} % and their complements

\newcommand{\BPP}{\class{BPP}}

\newcommand{\NP}{\class{NP}}

\newcommand{\RP}{\class{RP}}

\newcommand{\coRP}{\coclass{RP}}

\newcommand{\ZPP}{\class{ZPP}}

\newcommand{\BQP}{\class{BQP}}

\newcommand{\FP}{\class{FP}}

\newcommand{\QP}{\class{QuasiP}}

\newcommand{\VF}{\class{VF}}

\newcommand{\VBP}{\class{VBP}}

\newcommand{\VP}{\class{VP}}

\newcommand{\VNP}{\class{VNP}}

\newcommand{\RNC}{\class{RNC}}

\newcommand{\RL}{\class{RL}}

\newcommand{\BPL}{\class{BPL}}

\newcommand{\coRL}{\coclass{RL}}

\newcommand{\IP}{\class{IP}}

\newcommand{\AM}{\class{AM}}

\newcommand{\MA}{\class{MA}}

\newcommand{\QMA}{\class{QMA}}

\newcommand{\SBP}{\class{SBP}}

\newcommand{\coAM}{\class{coAM}}

\newcommand{\coMA}{\class{coMA}}

\renewcommand{\P}{\class{P}}

\newcommand\prBPP{\class{prBPP}}

\newcommand\prRP{\class{prRP}}

\newcommand\prP{\class{prP}}

\newcommand{\Ppoly}{\class{P/poly}}

\newcommand{\NPpoly}{\class{NP/poly}}

\newcommand{\coNPpoly}{\class{coNP/poly}}

\newcommand{\DTIME}{\class{DTIME}}

\newcommand{\TIME}{\class{TIME}}

\newcommand{\SIZE}{\class{SIZE}}

\newcommand{\SPACE}{\class{SPACE}}

\newcommand{\ETIME}{\class{E}}

\newcommand{\BPTIME}{\class{BPTIME}}

\newcommand{\RPTIME}{\class{RPTIME}}

\newcommand{\ZPTIME}{\class{ZPTIME}}

\newcommand{\EXP}{\class{EXP}}

\newcommand{\ZPEXP}{\class{ZPEXP}}

\newcommand{\RPEXP}{\class{RPEXP}}

\newcommand{\BPEXP}{\class{BPEXP}}

\newcommand{\SUBEXP}{\class{SUBEXP}}

\newcommand{\NTIME}{\class{NTIME}}

\newcommand{\NL}{\class{NL}}

\renewcommand{\L}{\class{L}}

\newcommand{\NQP}{\class{NQP}}

\newcommand{\NEXP}{\class{NEXP}}

\newcommand{\coNEXP}{\coclass{NEXP}}

\newcommand{\NPSPACE}{\class{NPSPACE}}

\newcommand{\PSPACE}{\class{PSPACE}}

\newcommand{\NSPACE}{\class{NSPACE}}

\newcommand{\coNSPACE}{\coclass{NSPACE}}

\newcommand{\coL}{\coclass{L}}

\newcommand{\coP}{\coclass{P}}

\newcommand{\coNP}{\coclass{NP}}

\newcommand{\coNL}{\coclass{NL}}

\newcommand{\coNPSPACE}{\coclass{NPSPACE}}

\newcommand{\APSPACE}{\class{APSPACE}}

\newcommand{\LINSPACE}{\class{LINSPACE}}

\newcommand{\qP}{\class{\tilde{P}}}

\newcommand{\PH}{\class{PH}}

\newcommand{\EXPSPACE}{\class{EXPSPACE}}

\newcommand{\SigmaTIME}[1]{\class{\Sigma_{#1}TIME}}

\newcommand{\PiTIME}[1]{\class{\Pi_{#1}TIME}}

\newcommand{\SigmaP}[1]{\class{\Sigma_{#1}P}}

\newcommand{\PiP}[1]{\class{\Pi_{#1}P}}

\newcommand{\DeltaP}[1]{\class{\Delta_{#1}P}}

\newcommand{\ATIME}{\class{ATIME}}

\newcommand{\ASPACE}{\class{ASPACE}}

\newcommand{\AP}{\class{AP}}

\newcommand{\AL}{\class{AL}}

\newcommand{\APSPACE}{\class{APSPACE}}

\newcommand{\VNC}[1]{\class{VNC^{#1}}}

\newcommand{\NC}[1]{\class{NC^{#1}}}

\newcommand{\AC}[1]{\class{AC^{#1}}}

\newcommand{\ACC}[1]{\class{ACC^{#1}}}

\newcommand{\TC}[1]{\class{TC^{#1}}}

\newcommand{\ShP}{\class{\# P}}

\newcommand{\PaP}{\class{\oplus P}}

\newcommand{\PCP}{\class{PCP}}

\newcommand{\kMIP}[1]{\class{#1\mbox{-}MIP}}

\newcommand{\MIP}{\class{MIP}}

$

$

\newcommand{\textprob}[1]{\text{#1}}

\newcommand{\mathprob}[1]{\textbf{#1}}

\newcommand{\Satisfiability}{\textprob{Satisfiability}}

\newcommand{\SAT}{\textprob{SAT}}

\newcommand{\TSAT}{\textprob{3SAT}}

\newcommand{\USAT}{\textprob{USAT}}

\newcommand{\UNSAT}{\textprob{UNSAT}}

\newcommand{\QPSAT}{\textprob{QPSAT}}

\newcommand{\TQBF}{\textprob{TQBF}}

\newcommand{\LinProg}{\textprob{Linear Programming}}

\newcommand{\LP}{\mathprob{LP}}

\newcommand{\Factor}{\textprob{Factoring}}

\newcommand{\CircVal}{\textprob{Circuit Value}}

\newcommand{\CVAL}{\mathprob{CVAL}}

\newcommand{\CircSat}{\textprob{Circuit Satisfiability}}

\newcommand{\CSAT}{\textprob{CSAT}}

\newcommand{\CycleCovers}{\textprob{Cycle Covers}}

\newcommand{\MonCircVal}{\textprob{Monotone Circuit Value}}

\newcommand{\Reachability}{\textprob{Reachability}}

\newcommand{\Unreachability}{\textprob{Unreachability}}

\newcommand{\RCH}{\mathprob{RCH}}

\newcommand{\BddHalt}{\textprob{Bounded Halting}}

\newcommand{\BH}{\mathprob{BH}}

\newcommand{\DiscreteLog}{\textprob{Discrete Log}}

\newcommand{\REE}{\mathprob{REE}}

\newcommand{\QBF}{\mathprob{QBF}}

\newcommand{\MCSP}{\mathprob{MCSP}}

\newcommand{\GGEO}{\mathprob{GGEO}}

\newcommand{\CKTMIN}{\mathprob{CKT-MIN}}

\newcommand{\MINCKT}{\mathprob{MIN-CKT}}

\newcommand{\IdentityTest}{\textprob{Identity Testing}}

\newcommand{\Majority}{\textprob{Majority}}

\newcommand{\CountIndSets}{\textprob{\#Independent Sets}}

\newcommand{\Parity}{\textprob{Parity}}

\newcommand{\Clique}{\textprob{Clique}}

\newcommand{\CountCycles}{\textprob{#Cycles}}

\newcommand{\CountPerfMatchings}{\textprob{\#Perfect Matchings}}

\newcommand{\CountMatchings}{\textprob{\#Matchings}}

\newcommand{\CountMatch}{\mathprob{\#Matchings}}

\newcommand{\ECSAT}{\mathprob{E#SAT}}

\newcommand{\ShSAT}{\mathprob{#SAT}}

\newcommand{\ShTSAT}{\mathprob{#3SAT}}

\newcommand{\HamCycle}{\textprob{Hamiltonian Cycle}}

\newcommand{\Permanent}{\textprob{Permanent}}

\newcommand{\ModPermanent}{\textprob{Modular Permanent}}

\newcommand{\GraphNoniso}{\textprob{Graph Nonisomorphism}}

\newcommand{\GI}{\mathprob{GI}}

\newcommand{\GNI}{\mathprob{GNI}}

\newcommand{\GraphIso}{\textprob{Graph Isomorphism}}

\newcommand{\QuantBoolForm}{\textprob{Quantified Boolean

Formulae}}

\newcommand{\GenGeography}{\textprob{Generalized Geography}}

\newcommand{\MAXTSAT}{\mathprob{Max3SAT}}

\newcommand{\GapMaxTSAT}{\mathprob{GapMax3SAT}}

\newcommand{\ELIN}{\mathprob{E3LIN2}}

\newcommand{\CSP}{\mathprob{CSP}}

\newcommand{\Lin}{\mathprob{Lin}}

\newcommand{\ONE}{\mathbf{ONE}}

\newcommand{\ZERO}{\mathbf{ZERO}}

\newcommand{\yes}

\newcommand{\no}

$

$

\newcommand{\undefined}{}

\newcommand{\hfill}{}

\newcommand{\qedhere}{\square}

\newcommand{\qed}{\square}

\newcommand{\ensuremath}[1]{#1}

\newcommand{\bit}{\{0,1\}}

\newcommand{\Bit}{\{-1,1\}}

\newcommand{\Stab}{\mathbf{Stab}}

\newcommand{\NS}{\mathbf{NS}}

\newcommand{\ba}{\mathbf{a}}

\newcommand{\bc}{\mathbf{c}}

\newcommand{\bd}{\mathbf{d}}

\newcommand{\be}{\mathbf{e}}

\newcommand{\bh}{\mathbf{h}}

\newcommand{\br}{\mathbf{r}}

\newcommand{\bs}{\mathbf{s}}

\newcommand{\bx}{\mathbf{x}}

\newcommand{\by}{\mathbf{y}}

\newcommand{\bz}{\mathbf{z}}

\newcommand{\Var}{\mathbf{Var}}

\newcommand{\dist}{\text{dist}}

\newcommand{\norm}[1]{\\|#1\\|}

\newcommand{\etal}

\newcommand{\ie}

\newcommand{\eg}

\newcommand{\cf}

\newcommand{\rank}{\text{rank}}

\newcommand{\tr}{\text{tr}}

\newcommand{\mor}{\text{Mor}}

\newcommand{\hom}{\text{Hom}}

\newcommand{\id}{\text{id}}

\newcommand{\obj}{\text{obj}}

\newcommand{\pr}{\text{pr}}

\newcommand{\ker}{\text{ker}}

\newcommand{\coker}{\text{coker}}

\newcommand{\im}{\text{im}}

\newcommand{\vol}{\text{vol}}

\newcommand{\disc}{\text{disc}}

\newcommand{\bbA}{\mathbb A}

\newcommand{\bbB}{\mathbb B}

\newcommand{\bbC}{\mathbb C}

\newcommand{\bbD}{\mathbb D}

\newcommand{\bbE}{\mathbb E}

\newcommand{\bbF}{\mathbb F}

\newcommand{\bbG}{\mathbb G}

\newcommand{\bbH}{\mathbb H}

\newcommand{\bbI}{\mathbb I}

\newcommand{\bbJ}{\mathbb J}

\newcommand{\bbK}{\mathbb K}

\newcommand{\bbL}{\mathbb L}

\newcommand{\bbM}{\mathbb M}

\newcommand{\bbN}{\mathbb N}

\newcommand{\bbO}{\mathbb O}

\newcommand{\bbP}{\mathbb P}

\newcommand{\bbQ}{\mathbb Q}

\newcommand{\bbR}{\mathbb R}

\newcommand{\bbS}{\mathbb S}

\newcommand{\bbT}{\mathbb T}

\newcommand{\bbU}{\mathbb U}

\newcommand{\bbV}{\mathbb V}

\newcommand{\bbW}{\mathbb W}

\newcommand{\bbX}{\mathbb X}

\newcommand{\bbY}{\mathbb Y}

\newcommand{\bbZ}{\mathbb Z}

\newcommand{\sA}{\mathscr A}

\newcommand{\sB}{\mathscr B}

\newcommand{\sC}{\mathscr C}

\newcommand{\sD}{\mathscr D}

\newcommand{\sE}{\mathscr E}

\newcommand{\sF}{\mathscr F}

\newcommand{\sG}{\mathscr G}

\newcommand{\sH}{\mathscr H}

\newcommand{\sI}{\mathscr I}

\newcommand{\sJ}{\mathscr J}

\newcommand{\sK}{\mathscr K}

\newcommand{\sL}{\mathscr L}

\newcommand{\sM}{\mathscr M}

\newcommand{\sN}{\mathscr N}

\newcommand{\sO}{\mathscr O}

\newcommand{\sP}{\mathscr P}

\newcommand{\sQ}{\mathscr Q}

\newcommand{\sR}{\mathscr R}

\newcommand{\sS}{\mathscr S}

\newcommand{\sT}{\mathscr T}

\newcommand{\sU}{\mathscr U}

\newcommand{\sV}{\mathscr V}

\newcommand{\sW}{\mathscr W}

\newcommand{\sX}{\mathscr X}

\newcommand{\sY}{\mathscr Y}

\newcommand{\sZ}{\mathscr Z}

\newcommand{\sfA}{\mathsf A}

\newcommand{\sfB}{\mathsf B}

\newcommand{\sfC}{\mathsf C}

\newcommand{\sfD}{\mathsf D}

\newcommand{\sfE}{\mathsf E}

\newcommand{\sfF}{\mathsf F}

\newcommand{\sfG}{\mathsf G}

\newcommand{\sfH}{\mathsf H}

\newcommand{\sfI}{\mathsf I}

\newcommand{\sfJ}{\mathsf J}

\newcommand{\sfK}{\mathsf K}

\newcommand{\sfL}{\mathsf L}

\newcommand{\sfM}{\mathsf M}

\newcommand{\sfN}{\mathsf N}

\newcommand{\sfO}{\mathsf O}

\newcommand{\sfP}{\mathsf P}

\newcommand{\sfQ}{\mathsf Q}

\newcommand{\sfR}{\mathsf R}

\newcommand{\sfS}{\mathsf S}

\newcommand{\sfT}{\mathsf T}

\newcommand{\sfU}{\mathsf U}

\newcommand{\sfV}{\mathsf V}

\newcommand{\sfW}{\mathsf W}

\newcommand{\sfX}{\mathsf X}

\newcommand{\sfY}{\mathsf Y}

\newcommand{\sfZ}{\mathsf Z}

\newcommand{\cA}{\mathcal A}

\newcommand{\cB}{\mathcal B}

\newcommand{\cC}{\mathcal C}

\newcommand{\cD}{\mathcal D}

\newcommand{\cE}{\mathcal E}

\newcommand{\cF}{\mathcal F}

\newcommand{\cG}{\mathcal G}

\newcommand{\cH}{\mathcal H}

\newcommand{\cI}{\mathcal I}

\newcommand{\cJ}{\mathcal J}

\newcommand{\cK}{\mathcal K}

\newcommand{\cL}{\mathcal L}

\newcommand{\cM}{\mathcal M}

\newcommand{\cN}{\mathcal N}

\newcommand{\cO}{\mathcal O}

\newcommand{\cP}{\mathcal P}

\newcommand{\cQ}{\mathcal Q}

\newcommand{\cR}{\mathcal R}

\newcommand{\cS}{\mathcal S}

\newcommand{\cT}{\mathcal T}

\newcommand{\cU}{\mathcal U}

\newcommand{\cV}{\mathcal V}

\newcommand{\cW}{\mathcal W}

\newcommand{\cX}{\mathcal X}

\newcommand{\cY}{\mathcal Y}

\newcommand{\cZ}{\mathcal Z}

\newcommand{\bfA}{\mathbf A}

\newcommand{\bfB}{\mathbf B}

\newcommand{\bfC}{\mathbf C}

\newcommand{\bfD}{\mathbf D}

\newcommand{\bfE}{\mathbf E}

\newcommand{\bfF}{\mathbf F}

\newcommand{\bfG}{\mathbf G}

\newcommand{\bfH}{\mathbf H}

\newcommand{\bfI}{\mathbf I}

\newcommand{\bfJ}{\mathbf J}

\newcommand{\bfK}{\mathbf K}

\newcommand{\bfL}{\mathbf L}

\newcommand{\bfM}{\mathbf M}

\newcommand{\bfN}{\mathbf N}

\newcommand{\bfO}{\mathbf O}

\newcommand{\bfP}{\mathbf P}

\newcommand{\bfQ}{\mathbf Q}

\newcommand{\bfR}{\mathbf R}

\newcommand{\bfS}{\mathbf S}

\newcommand{\bfT}{\mathbf T}

\newcommand{\bfU}{\mathbf U}

\newcommand{\bfV}{\mathbf V}

\newcommand{\bfW}{\mathbf W}

\newcommand{\bfX}{\mathbf X}

\newcommand{\bfY}{\mathbf Y}

\newcommand{\bfZ}{\mathbf Z}

\newcommand{\rmA}{\mathrm A}

\newcommand{\rmB}{\mathrm B}

\newcommand{\rmC}{\mathrm C}

\newcommand{\rmD}{\mathrm D}

\newcommand{\rmE}{\mathrm E}

\newcommand{\rmF}{\mathrm F}

\newcommand{\rmG}{\mathrm G}

\newcommand{\rmH}{\mathrm H}

\newcommand{\rmI}{\mathrm I}

\newcommand{\rmJ}{\mathrm J}

\newcommand{\rmK}{\mathrm K}

\newcommand{\rmL}{\mathrm L}

\newcommand{\rmM}{\mathrm M}

\newcommand{\rmN}{\mathrm N}

\newcommand{\rmO}{\mathrm O}

\newcommand{\rmP}{\mathrm P}

\newcommand{\rmQ}{\mathrm Q}

\newcommand{\rmR}{\mathrm R}

\newcommand{\rmS}{\mathrm S}

\newcommand{\rmT}{\mathrm T}

\newcommand{\rmU}{\mathrm U}

\newcommand{\rmV}{\mathrm V}

\newcommand{\rmW}{\mathrm W}

\newcommand{\rmX}{\mathrm X}

\newcommand{\rmY}{\mathrm Y}

\newcommand{\rmZ}{\mathrm Z}

\newcommand{\bb}{\mathbf{b}}

\newcommand{\bv}{\mathbf{v}}

\newcommand{\bw}{\mathbf{w}}

\newcommand{\bx}{\mathbf{x}}

\newcommand{\by}{\mathbf{y}}

\newcommand{\bz}{\mathbf{z}}

\newcommand{\paren}[1]{( #1 )}

\newcommand{\Paren}[1]{\left( #1 \right)}

\newcommand{\bigparen}[1]{\bigl( #1 \bigr)}

\newcommand{\Bigparen}[1]{\Bigl( #1 \Bigr)}

\newcommand{\biggparen}[1]{\biggl( #1 \biggr)}

\newcommand{\Biggparen}[1]{\Biggl( #1 \Biggr)}

\newcommand{\abs}[1]{\lvert #1 \rvert}

\newcommand{\Abs}[1]{\left\lvert #1 \right\rvert}

\newcommand{\bigabs}[1]{\bigl\lvert #1 \bigr\rvert}

\newcommand{\Bigabs}[1]{\Bigl\lvert #1 \Bigr\rvert}

\newcommand{\biggabs}[1]{\biggl\lvert #1 \biggr\rvert}

\newcommand{\Biggabs}[1]{\Biggl\lvert #1 \Biggr\rvert}

\newcommand{\card}[1]{\left| #1 \right|}

\newcommand{\Card}[1]{\left\lvert #1 \right\rvert}

\newcommand{\bigcard}[1]{\bigl\lvert #1 \bigr\rvert}

\newcommand{\Bigcard}[1]{\Bigl\lvert #1 \Bigr\rvert}

\newcommand{\biggcard}[1]{\biggl\lvert #1 \biggr\rvert}

\newcommand{\Biggcard}[1]{\Biggl\lvert #1 \Biggr\rvert}

\newcommand{\norm}[1]{\lVert #1 \rVert}

\newcommand{\Norm}[1]{\left\lVert #1 \right\rVert}

\newcommand{\bignorm}[1]{\bigl\lVert #1 \bigr\rVert}

\newcommand{\Bignorm}[1]{\Bigl\lVert #1 \Bigr\rVert}

\newcommand{\biggnorm}[1]{\biggl\lVert #1 \biggr\rVert}

\newcommand{\Biggnorm}[1]{\Biggl\lVert #1 \Biggr\rVert}

\newcommand{\iprod}[1]{\langle #1 \rangle}

\newcommand{\Iprod}[1]{\left\langle #1 \right\rangle}

\newcommand{\bigiprod}[1]{\bigl\langle #1 \bigr\rangle}

\newcommand{\Bigiprod}[1]{\Bigl\langle #1 \Bigr\rangle}

\newcommand{\biggiprod}[1]{\biggl\langle #1 \biggr\rangle}

\newcommand{\Biggiprod}[1]{\Biggl\langle #1 \Biggr\rangle}

\newcommand{\set}[1]{\lbrace #1 \rbrace}

\newcommand{\Set}[1]{\left\lbrace #1 \right\rbrace}

\newcommand{\bigset}[1]{\bigl\lbrace #1 \bigr\rbrace}

\newcommand{\Bigset}[1]{\Bigl\lbrace #1 \Bigr\rbrace}

\newcommand{\biggset}[1]{\biggl\lbrace #1 \biggr\rbrace}

\newcommand{\Biggset}[1]{\Biggl\lbrace #1 \Biggr\rbrace}

\newcommand{\bracket}[1]{\lbrack #1 \rbrack}

\newcommand{\Bracket}[1]{\left\lbrack #1 \right\rbrack}

\newcommand{\bigbracket}[1]{\bigl\lbrack #1 \bigr\rbrack}

\newcommand{\Bigbracket}[1]{\Bigl\lbrack #1 \Bigr\rbrack}

\newcommand{\biggbracket}[1]{\biggl\lbrack #1 \biggr\rbrack}

\newcommand{\Biggbracket}[1]{\Biggl\lbrack #1 \Biggr\rbrack}

\newcommand{\ucorner}[1]{\ulcorner #1 \urcorner}

\newcommand{\Ucorner}[1]{\left\ulcorner #1 \right\urcorner}

\newcommand{\bigucorner}[1]{\bigl\ulcorner #1 \bigr\urcorner}

\newcommand{\Bigucorner}[1]{\Bigl\ulcorner #1 \Bigr\urcorner}

\newcommand{\biggucorner}[1]{\biggl\ulcorner #1 \biggr\urcorner}

\newcommand{\Biggucorner}[1]{\Biggl\ulcorner #1 \Biggr\urcorner}

\newcommand{\ceil}[1]{\lceil #1 \rceil}

\newcommand{\Ceil}[1]{\left\lceil #1 \right\rceil}

\newcommand{\bigceil}[1]{\bigl\lceil #1 \bigr\rceil}

\newcommand{\Bigceil}[1]{\Bigl\lceil #1 \Bigr\rceil}

\newcommand{\biggceil}[1]{\biggl\lceil #1 \biggr\rceil}

\newcommand{\Biggceil}[1]{\Biggl\lceil #1 \Biggr\rceil}

\newcommand{\floor}[1]{\lfloor #1 \rfloor}

\newcommand{\Floor}[1]{\left\lfloor #1 \right\rfloor}

\newcommand{\bigfloor}[1]{\bigl\lfloor #1 \bigr\rfloor}

\newcommand{\Bigfloor}[1]{\Bigl\lfloor #1 \Bigr\rfloor}

\newcommand{\biggfloor}[1]{\biggl\lfloor #1 \biggr\rfloor}

\newcommand{\Biggfloor}[1]{\Biggl\lfloor #1 \Biggr\rfloor}

\newcommand{\lcorner}[1]{\llcorner #1 \lrcorner}

\newcommand{\Lcorner}[1]{\left\llcorner #1 \right\lrcorner}

\newcommand{\biglcorner}[1]{\bigl\llcorner #1 \bigr\lrcorner}

\newcommand{\Biglcorner}[1]{\Bigl\llcorner #1 \Bigr\lrcorner}

\newcommand{\bigglcorner}[1]{\biggl\llcorner #1 \biggr\lrcorner}

\newcommand{\Bigglcorner}[1]{\Biggl\llcorner #1 \Biggr\lrcorner}

\newcommand{\ket}[1]{| #1 \rangle}

\newcommand{\bra}[1]{\langle #1 |}

\newcommand{\braket}[2]{\langle #1 | #2 \rangle}

\newcommand{\ketbra}[1]{| #1 \rangle\langle #1 |}

\newcommand{\e}{\varepsilon}

\newcommand{\eps}{\varepsilon}

\newcommand{\from}{\colon}

\newcommand{\super}[2]{#1^{(#2)}}

\newcommand{\varsuper}[2]{#1^{\scriptscriptstyle (#2)}}

\newcommand{\tensor}{\otimes}

\newcommand{\eset}{\emptyset}

\newcommand{\sse}{\subseteq}

\newcommand{\sst}{\substack}

\newcommand{\ot}{\otimes}

\newcommand{\Esst}[1]{\bbE_{\substack{#1}}}

\newcommand{\vbig}{\vphantom{\bigoplus}}

\newcommand{\seteq}{\mathrel{\mathop:}=}

\newcommand{\defeq}{\stackrel{\mathrm{def}}=}

\newcommand{\Mid}{\mathrel{}\middle|\mathrel{}}

\newcommand{\Ind}{\mathbf 1}

\newcommand{\bits}{\{0,1\}}

\newcommand{\sbits}{\{\pm 1\}}

\newcommand{\R}{\mathbb R}

\newcommand{\Rnn}{\R_{\ge 0}}

\newcommand{\N}{\mathbb N}

\newcommand{\Z}{\mathbb Z}

\newcommand{\Q}{\mathbb Q}

\newcommand{\C}{\mathbb C}

\newcommand{\A}{\mathbb A}

\newcommand{\Real}{\mathbb R}

\newcommand{\mper}{\,.}

\newcommand{\mcom}{\,,}

\DeclareMathOperator{\Id}{Id}

\DeclareMathOperator{\cone}{cone}

\DeclareMathOperator{\vol}{vol}

\DeclareMathOperator{\val}{val}

\DeclareMathOperator{\opt}{opt}

\DeclareMathOperator{\Opt}{Opt}

\DeclareMathOperator{\Val}{Val}

\DeclareMathOperator{\LP}{LP}

\DeclareMathOperator{\SDP}{SDP}

\DeclareMathOperator{\Tr}{Tr}

\DeclareMathOperator{\Inf}{Inf}

\DeclareMathOperator{\size}{size}

\DeclareMathOperator{\poly}{poly}

\DeclareMathOperator{\polylog}{polylog}

\DeclareMathOperator{\min}{min}

\DeclareMathOperator{\max}{max}

\DeclareMathOperator{\argmax}{arg\,max}

\DeclareMathOperator{\argmin}{arg\,min}

\DeclareMathOperator{\qpoly}{qpoly}

\DeclareMathOperator{\qqpoly}{qqpoly}

\DeclareMathOperator{\conv}{conv}

\DeclareMathOperator{\Conv}{Conv}

\DeclareMathOperator{\supp}{supp}

\DeclareMathOperator{\sign}{sign}

\DeclareMathOperator{\perm}{perm}

\DeclareMathOperator{\mspan}{span}

\DeclareMathOperator{\mrank}{rank}

\DeclareMathOperator{\E}{\mathbb E}

\DeclareMathOperator{\pE}{\tilde{\mathbb E}}

\DeclareMathOperator{\Pr}{\mathbb P}

\DeclareMathOperator{\Span}{Span}

\DeclareMathOperator{\Cone}{Cone}

\DeclareMathOperator{\junta}{junta}

\DeclareMathOperator{\NSS}{NSS}

\DeclareMathOperator{\SA}{SA}

\DeclareMathOperator{\SOS}{SOS}

\DeclareMathOperator{\Stab}{\mathbf Stab}

\DeclareMathOperator{\Det}{\textbf{Det}}

\DeclareMathOperator{\Perm}{\textbf{Perm}}

\DeclareMathOperator{\Sym}{\textbf{Sym}}

\DeclareMathOperator{\Pow}{\textbf{Pow}}

\DeclareMathOperator{\Gal}{\textbf{Gal}}

\DeclareMathOperator{\Aut}{\textbf{Aut}}

\newcommand{\iprod}[1]{\langle #1 \rangle}

\newcommand{\cE}{\mathcal{E}}

\newcommand{\E}{\mathbb{E}}

\newcommand{\pE}{\tilde{\mathbb{E}}}

\newcommand{\N}{\mathbb{N}}

\renewcommand{\P}{\mathcal{P}}

\notag

$

$

\newcommand{\sleq}{\ensuremath{\preceq}}

\newcommand{\sgeq}{\ensuremath{\succeq}}

\newcommand{\diag}{\ensuremath{\mathrm{diag}}}

\newcommand{\support}{\ensuremath{\mathrm{support}}}

\newcommand{\zo}{\ensuremath{\{0,1\}}}

\newcommand{\pmo}{\ensuremath{\{\pm 1\}}}

\newcommand{\uppersos}{\ensuremath{\overline{\mathrm{sos}}}}

\newcommand{\lambdamax}{\ensuremath{\lambda_{\mathrm{max}}}}

\newcommand{\rank}{\ensuremath{\mathrm{rank}}}

\newcommand{\Mslow}{\ensuremath{M_{\mathrm{slow}}}}

\newcommand{\Mfast}{\ensuremath{M_{\mathrm{fast}}}}

\newcommand{\Mdiag}{\ensuremath{M_{\mathrm{diag}}}}

\newcommand{\Mcross}{\ensuremath{M_{\mathrm{cross}}}}

\newcommand{\eqdef}{\ensuremath{ =^{def}}}

\newcommand{\threshold}{\ensuremath{\mathrm{threshold}}}

\newcommand{\vbls}{\ensuremath{\mathrm{vbls}}}

\newcommand{\cons}{\ensuremath{\mathrm{cons}}}

\newcommand{\edges}{\ensuremath{\mathrm{edges}}}

\newcommand{\cl}{\ensuremath{\mathrm{cl}}}

\newcommand{\xor}{\ensuremath{\oplus}}

\newcommand{\1}{\ensuremath{\mathrm{1}}}

\notag

$

$

\newcommand{\transpose}[1]{\ensuremath{#1{}^{\mkern-2mu\intercal}}}

\newcommand{\dyad}[1]{\ensuremath{#1#1{}^{\mkern-2mu\intercal}}}

\newcommand{\nchoose}[1]{\ensuremath}

\newcommand{\generated}[1]{\ensuremath{\langle #1 \rangle}}

\notag

$

$

\newcommand{\eqdef}{\mathbin{\stackrel{\rm def}{=}}}

\newcommand{\R} % real numbers

\newcommand{\N}} % natural numbers

\newcommand{\Z} % integers

\newcommand{\F} % a field

\newcommand{\Q} % the rationals

\newcommand{\C}{\mathbb{C}} % the complexes

\newcommand{\poly}}

\newcommand{\polylog}}

\newcommand{\loglog}}}

\newcommand{\zo}{\{0,1\}}

\newcommand{\suchthat}

\newcommand{\pr}[1]{\Pr\left[#1\right]}

\newcommand{\deffont}{\em}

\newcommand{\getsr}{\mathbin{\stackrel{\mbox{\tiny R}}{\gets}}}

\newcommand{\Exp}{\mathop{\mathrm E}\displaylimits} % expectation

\newcommand{\Var}{\mathop{\mathrm Var}\displaylimits} % variance

\newcommand{\xor}{\oplus}

\newcommand{\GF}{\mathrm{GF}}

\newcommand{\eps}{\varepsilon}

\notag

$

$

\newcommand{\class}[1]{\mathbf{#1}}

\newcommand{\coclass}[1]{\mathbf{co\mbox{-}#1}} % and their complements

\newcommand{\BPP}{\class{BPP}}

\newcommand{\NP}{\class{NP}}

\newcommand{\RP}{\class{RP}}

\newcommand{\coRP}{\coclass{RP}}

\newcommand{\ZPP}{\class{ZPP}}

\newcommand{\BQP}{\class{BQP}}

\newcommand{\FP}{\class{FP}}

\newcommand{\QP}{\class{QuasiP}}

\newcommand{\VF}{\class{VF}}

\newcommand{\VBP}{\class{VBP}}

\newcommand{\VP}{\class{VP}}

\newcommand{\VNP}{\class{VNP}}

\newcommand{\RNC}{\class{RNC}}

\newcommand{\RL}{\class{RL}}

\newcommand{\BPL}{\class{BPL}}

\newcommand{\coRL}{\coclass{RL}}

\newcommand{\IP}{\class{IP}}

\newcommand{\AM}{\class{AM}}

\newcommand{\MA}{\class{MA}}

\newcommand{\QMA}{\class{QMA}}

\newcommand{\SBP}{\class{SBP}}

\newcommand{\coAM}{\class{coAM}}

\newcommand{\coMA}{\class{coMA}}

\renewcommand{\P}{\class{P}}

\newcommand\prBPP{\class{prBPP}}

\newcommand\prRP{\class{prRP}}

\newcommand\prP{\class{prP}}

\newcommand{\Ppoly}{\class{P/poly}}

\newcommand{\NPpoly}{\class{NP/poly}}

\newcommand{\coNPpoly}{\class{coNP/poly}}

\newcommand{\DTIME}{\class{DTIME}}

\newcommand{\TIME}{\class{TIME}}

\newcommand{\SIZE}{\class{SIZE}}

\newcommand{\SPACE}{\class{SPACE}}

\newcommand{\ETIME}{\class{E}}

\newcommand{\BPTIME}{\class{BPTIME}}

\newcommand{\RPTIME}{\class{RPTIME}}

\newcommand{\ZPTIME}{\class{ZPTIME}}

\newcommand{\EXP}{\class{EXP}}

\newcommand{\ZPEXP}{\class{ZPEXP}}

\newcommand{\RPEXP}{\class{RPEXP}}

\newcommand{\BPEXP}{\class{BPEXP}}

\newcommand{\SUBEXP}{\class{SUBEXP}}

\newcommand{\NTIME}{\class{NTIME}}

\newcommand{\NL}{\class{NL}}

\renewcommand{\L}{\class{L}}

\newcommand{\NQP}{\class{NQP}}

\newcommand{\NEXP}{\class{NEXP}}

\newcommand{\coNEXP}{\coclass{NEXP}}

\newcommand{\NPSPACE}{\class{NPSPACE}}

\newcommand{\PSPACE}{\class{PSPACE}}

\newcommand{\NSPACE}{\class{NSPACE}}

\newcommand{\coNSPACE}{\coclass{NSPACE}}

\newcommand{\coL}{\coclass{L}}

\newcommand{\coP}{\coclass{P}}

\newcommand{\coNP}{\coclass{NP}}

\newcommand{\coNL}{\coclass{NL}}

\newcommand{\coNPSPACE}{\coclass{NPSPACE}}

\newcommand{\APSPACE}{\class{APSPACE}}

\newcommand{\LINSPACE}{\class{LINSPACE}}

\newcommand{\qP}{\class{\tilde{P}}}

\newcommand{\PH}{\class{PH}}

\newcommand{\EXPSPACE}{\class{EXPSPACE}}

\newcommand{\SigmaTIME}[1]{\class{\Sigma_{#1}TIME}}

\newcommand{\PiTIME}[1]{\class{\Pi_{#1}TIME}}

\newcommand{\SigmaP}[1]{\class{\Sigma_{#1}P}}

\newcommand{\PiP}[1]{\class{\Pi_{#1}P}}

\newcommand{\DeltaP}[1]{\class{\Delta_{#1}P}}

\newcommand{\ATIME}{\class{ATIME}}

\newcommand{\ASPACE}{\class{ASPACE}}

\newcommand{\AP}{\class{AP}}

\newcommand{\AL}{\class{AL}}

\newcommand{\APSPACE}{\class{APSPACE}}

\newcommand{\VNC}[1]{\class{VNC^{#1}}}

\newcommand{\NC}[1]{\class{NC^{#1}}}

\newcommand{\AC}[1]{\class{AC^{#1}}}

\newcommand{\ACC}[1]{\class{ACC^{#1}}}

\newcommand{\TC}[1]{\class{TC^{#1}}}

\newcommand{\ShP}{\class{\# P}}

\newcommand{\PaP}{\class{\oplus P}}

\newcommand{\PCP}{\class{PCP}}

\newcommand{\kMIP}[1]{\class{#1\mbox{-}MIP}}

\newcommand{\MIP}{\class{MIP}}

$

$

\newcommand{\textprob}[1]{\text{#1}}

\newcommand{\mathprob}[1]{\textbf{#1}}

\newcommand{\Satisfiability}{\textprob{Satisfiability}}

\newcommand{\SAT}{\textprob{SAT}}

\newcommand{\TSAT}{\textprob{3SAT}}

\newcommand{\USAT}{\textprob{USAT}}

\newcommand{\UNSAT}{\textprob{UNSAT}}

\newcommand{\QPSAT}{\textprob{QPSAT}}

\newcommand{\TQBF}{\textprob{TQBF}}

\newcommand{\LinProg}{\textprob{Linear Programming}}

\newcommand{\LP}{\mathprob{LP}}

\newcommand{\Factor}{\textprob{Factoring}}

\newcommand{\CircVal}{\textprob{Circuit Value}}

\newcommand{\CVAL}{\mathprob{CVAL}}

\newcommand{\CircSat}{\textprob{Circuit Satisfiability}}

\newcommand{\CSAT}{\textprob{CSAT}}

\newcommand{\CycleCovers}{\textprob{Cycle Covers}}

\newcommand{\MonCircVal}{\textprob{Monotone Circuit Value}}

\newcommand{\Reachability}{\textprob{Reachability}}

\newcommand{\Unreachability}{\textprob{Unreachability}}

\newcommand{\RCH}{\mathprob{RCH}}

\newcommand{\BddHalt}{\textprob{Bounded Halting}}

\newcommand{\BH}{\mathprob{BH}}

\newcommand{\DiscreteLog}{\textprob{Discrete Log}}

\newcommand{\REE}{\mathprob{REE}}

\newcommand{\QBF}{\mathprob{QBF}}

\newcommand{\MCSP}{\mathprob{MCSP}}

\newcommand{\GGEO}{\mathprob{GGEO}}

\newcommand{\CKTMIN}{\mathprob{CKT-MIN}}

\newcommand{\MINCKT}{\mathprob{MIN-CKT}}

\newcommand{\IdentityTest}{\textprob{Identity Testing}}

\newcommand{\Majority}{\textprob{Majority}}

\newcommand{\CountIndSets}{\textprob{\#Independent Sets}}

\newcommand{\Parity}{\textprob{Parity}}

\newcommand{\Clique}{\textprob{Clique}}

\newcommand{\CountCycles}{\textprob{#Cycles}}

\newcommand{\CountPerfMatchings}{\textprob{\#Perfect Matchings}}

\newcommand{\CountMatchings}{\textprob{\#Matchings}}

\newcommand{\CountMatch}{\mathprob{\#Matchings}}

\newcommand{\ECSAT}{\mathprob{E#SAT}}

\newcommand{\ShSAT}{\mathprob{#SAT}}

\newcommand{\ShTSAT}{\mathprob{#3SAT}}

\newcommand{\HamCycle}{\textprob{Hamiltonian Cycle}}

\newcommand{\Permanent}{\textprob{Permanent}}

\newcommand{\ModPermanent}{\textprob{Modular Permanent}}

\newcommand{\GraphNoniso}{\textprob{Graph Nonisomorphism}}

\newcommand{\GI}{\mathprob{GI}}

\newcommand{\GNI}{\mathprob{GNI}}

\newcommand{\GraphIso}{\textprob{Graph Isomorphism}}

\newcommand{\QuantBoolForm}{\textprob{Quantified Boolean

Formulae}}

\newcommand{\GenGeography}{\textprob{Generalized Geography}}

\newcommand{\MAXTSAT}{\mathprob{Max3SAT}}

\newcommand{\GapMaxTSAT}{\mathprob{GapMax3SAT}}

\newcommand{\ELIN}{\mathprob{E3LIN2}}

\newcommand{\CSP}{\mathprob{CSP}}

\newcommand{\Lin}{\mathprob{Lin}}

\newcommand{\ONE}{\mathbf{ONE}}

\newcommand{\ZERO}{\mathbf{ZERO}}

\newcommand{\yes}

\newcommand{\no}

$

Blog

A place to record my feeling, my thought, my exploration, and my growth. Since I intend to be casual here so I decided to use Madarin for most of the posts. I'll translate some of the posts into English on request and put it

here.

09 Sep 2023

(See here for an English version)

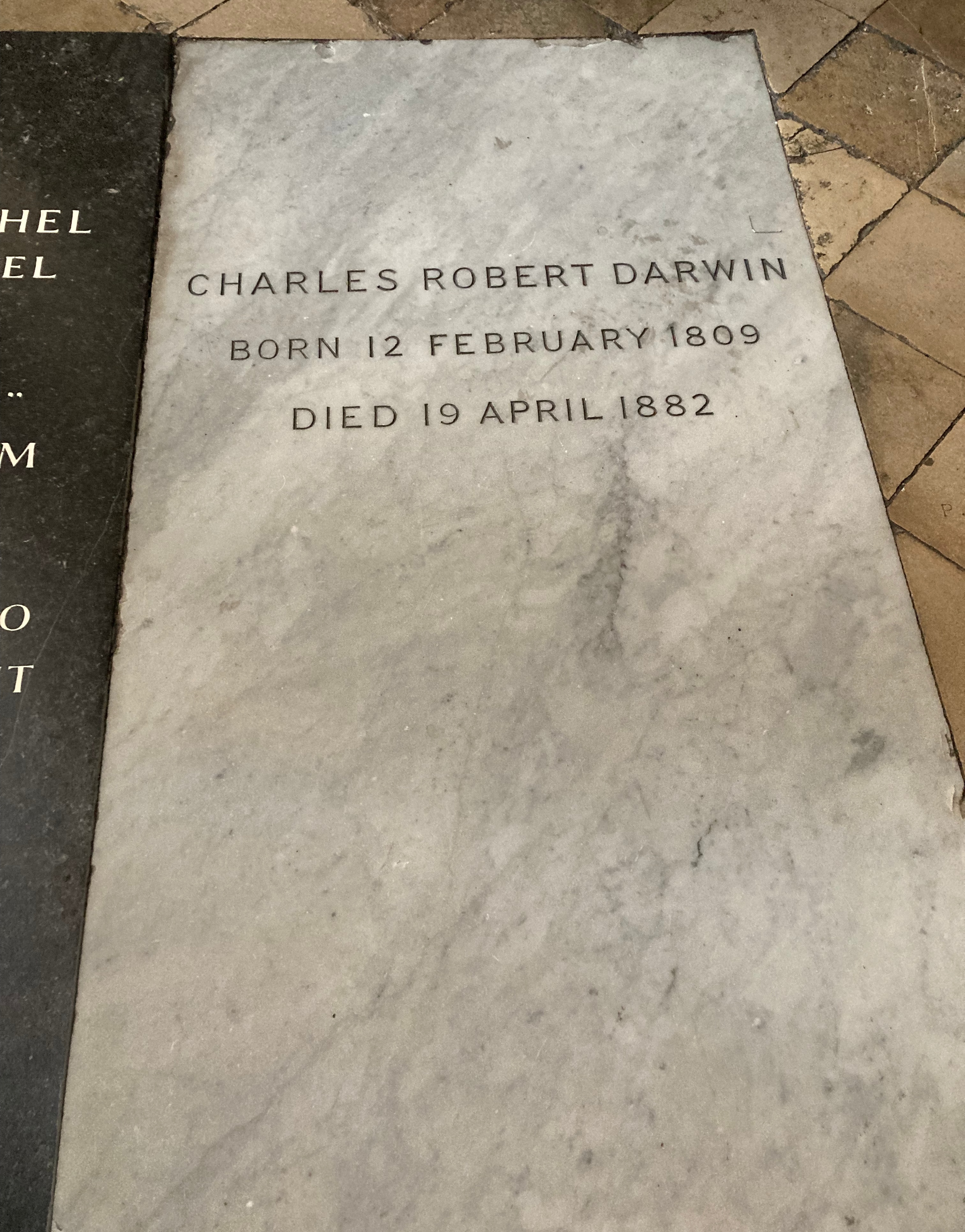

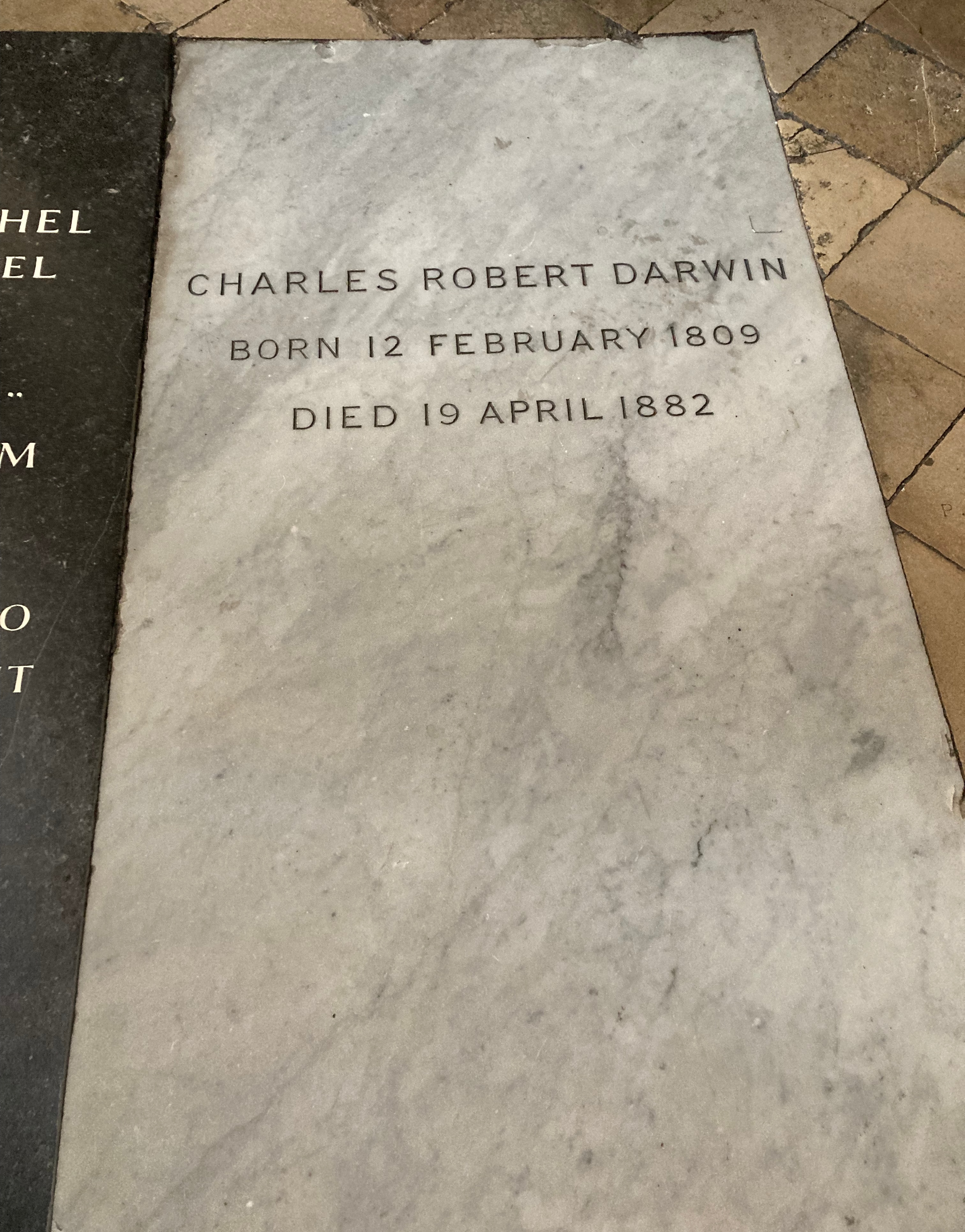

九月初的倫敦迎來了今年最後一波(希望如此)熱浪,匆匆吃完早餐後,懷著像是要和聊了多年的網友見面般的心情,頂著艷陽前往已經路過好多次的西敏寺(Westminister Abbey)。雖然終究無法真的面對面見到這些認識多年的偉人,但就像聊天時人們也時常是用著自己的想像在理解和詮釋對方的話語,今天我還是滿心期待地要來和幾位仰慕許久的科學家暢聊一番。

才剛擦完汗冷靜下來,一轉眼就看到達爾文站在第一個轉角進入主廳(naive)的門口處,看著他尷尬地望著魚貫的遊客行經身旁,偶爾有幾個人停下驚呼:「喔這就是那個發明演化理論的男人!」,我趕緊在ㄧ旁找到個小角落,微微笑地站在一旁觀察著。

終於一不小心對到眼,我輕輕地點頭示意,場景突然像是換到了學術會議的交流場合,我把握機會迅速簡單地介紹了自己,並且表達對達爾文的崇敬,只不過不太確定當時在學術界大家是否也是會輕鬆地直呼對方名字,保險起見還是稱他為教授好了。看著他一臉迷糊的樣子,我緊張了一下,不知道是不是自己說錯了什麼話。

空氣停滯了幾秒之後,達爾文用著濃厚的英國紳士腔開口:「我其實不太知道你說的『電腦』和『腦神經』是什麼,不過既然你說你很喜歡我的研究,也許你可以多說說為什麼,然後和你的研究有什麼關聯呢?」

糟糕,我完全忘記電腦科學和腦神經科學都是二十世紀才漸漸萌芽成熟的,看來真的要小心不能隨意假設對方的背景知識呀。「真是冒犯了,您如果想多知道電腦和腦神經科學在做些什麼,我等下可以慢慢解釋給您。」

我緊張地咽了一下口水。「您提出的演化論,是少數我見過能夠乾淨地連結由上而下的功能層次和由下而上的機械層次的理論。」喔不,我又忘記他可能不知道分子生物學以及演化論的近代詮釋(modern synthesis),但誰知道呢,說不定當時他早就預知這些了。「而且我很喜歡天擇(nature selection)的概念,它不像一般物理的原則是在最佳化某些方程式,這種開放性的數學原則,讓我覺得是了解生命、智能與意識的關鍵。不過我還沒有什麼具體的理論架構,希望未來三十年我可以慢慢找的一些雛形…」

「嗯,我沒有完全聽得懂你在說些什麼,不過演化論並不是我一個人作品,別忘了華勒斯(Wallace)他其實同時獨立想出了一樣的理論。」達爾文邊說邊摸著鬍子看向遠方。

「啊沒錯,我也很想跟您說,我非常敬佩您和華勒斯之間的相知相惜,真希望現今學術界的人們可以向你們多多學習,別一天到晚爭功諉過搞政治…」哎呀為什麼每次和大佬說話時,總是有太多想說的,結果東漏西漏,文不成章。

「或許這也是社會演化的過程吧。」達爾文說這句話時,雙眼清澈,不帶一絲情緒。

漸漸地兩人的表情都轉為禮貌性的微笑,有時候這種人多的場合大概真的很難慢慢深聊吧,瞥見一旁擠著拍著的人們,才發現自己不小心太激動站到了路中間,於是趕緊點個頭致意然後些微尷尬地鑽出了人群。

走到長廊的盡頭,來到東側(CHECK)寬廣的廳堂,金碧輝煌的XX正對著西敏寺著名的無名氏之墓(CHECK),看著這位身穿破舊軍服的年輕人被一群衣著富麗端莊的皇族、政治家與科學家等等包圍,同時無數來參觀的老百姓興高采烈地索取自拍,甚至是進行直播。我蠻好奇他會怎麼描述他的生活,更想知道他原本到底是什麼樣的一個人,不過人潮實在是源源不絕,我只能站在一旁的角落探頭晃腦。

「這些現代人真是忘恩負義,當年要不是我們這些重要人物的努力和付出,怎麼會有現在的太平盛世。怎麼來了這邊都不找我們說說話,反倒一直圍在那個不知道從哪裡冒出來的小子身旁,哎真是悶得發慌呀…」我繼續維持著往遠處望的視線,同時若無其事的繼續偷聽著身後兩位老先生的對話。

「話也不是這麼說的啦,就像當年我們沒辦法沒有這些成千上萬的無名士兵幫我們打天下,要是沒有這個小夥子,不知道一年會少多少人來拜訪西敏寺呢!」

我的腦海中突然浮現出兩位老教授,正在用著相似的語氣討論如何讓實驗室的學生好好工作,歷史在各個時代和不同領域間竟然有如此相似的劇情,讓我不禁捏了把冷汗。一回過神來我不禁眨了眨幾下眼睛,身後的兩個老頭應該是發現到了我在偷聽,一陣突如襲來的沈默在不遠處的喧囂包圍之下,顯得特別不真實。

我摸摸鼻子一副若無其事的樣子隨著人流繼續往前走,ㄧ抬頭眼睛突然一陣暈眩,四周的吵雜像是被真空抽走了般,看到這麼多重量級的科學家在眼前一字排開,我突然能理解為什麼有些人在看到明星偶像時會昏過去了。

不過隨之而來的馬上是一股股罪惡感,對於自己還有好多預計要讀但卻塵封已久的物理教科書和論文,不禁有點害怕和霍金教授或是狄拉克教授對到眼,深怕每講幾句就被發現自己學識淺薄。但是一想到霍金輻射和消息悖論,還有狄拉克方程式的美以及狄拉克符號、狄拉克函數等等,影響了將近一半我在讀博士期間的學習和研究,雖然有點擔心不小心對到眼,我還是小小聲地在心裡像他們表達了崇敬與感謝。

一位穿著看起來比達爾文更古老更華麗的紳士,坐在一個特別大且精雕細琢的石棺上,似乎對於絡繹不絕的人潮早已見怪不怪。困惑了幾秒後,我才驚覺這不就是牛頓嗎!可能是國高中時期都沒有好好讀課本,竟然對於牛頓的長相沒有什麼概念,一時之間有點難把這個英俊的臉龐和近代科學的開創人聯繫起來。

過去幾年來,隨著許多的科學哲學思考與閱讀,還有廣泛接觸各個物理子領域,和更近代一些關於複雜系統的研究,我對於牛頓當年開天闢地般的貢獻,不但有了更深的理解,同時也很好奇他對於科學發展的看法。

「牛頓爵士您好。」這次我有些心理準備了,隨然霍金等人是他的鄰居,但不見得代表牛頓有跟上物理學在他之後幾百年的發展。「您曾說過『如果我們能夠理解自然,那必定是透過微分方程。』我很好奇當系統中的物體變多變複雜後,您覺得微分方程真的還有希望嗎?例如三體問題到現在都還沒有被解決。」心裡一閃而過想要提一下計算複雜度、Church-Turing thesis等等的,不過還是先緩一下好了。

「我有這樣說過呀!」牛頓微微皺了一下眉頭。「微分方程真是美妙的東西,誰能不愛微分方程呢!?」

「是呀是呀。」我趕緊附和著,雖然有點不好意思告訴他其實我從來沒有上過一堂微分方程的課…

「我想我的意思是,我想不太到有什麼微分方程以外的方式來理解世界。」牛頓漸漸放慢了語速。「雖然我實在很難想像,不過誰知道,說不定我是錯的,你有什麼比較好的方法嗎?」

「不知道您有沒有聽過『電腦科學』?」看到他露出迷茫的眼神,我趕緊補充到。「你可以把電腦想成是一種機械化且離散的數學模型,可以用來嘗試描述人類思考的方式。」

「而且現在人們可以實際把電腦做成真實的機器,並且在上面做複雜運算,例如解微分方程!」

「好喔,我還是沒有很知道你說的這個『電腦』跟理解世界有什麼關係呢。」

真沒想到牛頓還願意再給我機會解釋。我迅速地想了一下該如何用最簡短的方式告訴他。

「想像一下如果你有無限多的時間還有很多紙筆可以做計算。」

「時間我現在多的是呢,紙筆倒是不太夠。」也不知道牛頓是在幽默一下,還是只是下意識地喃喃自語。

「如此一來你可以把感興趣的系統在紙上完整地寫下來,然後不斷地用你最愛的微分方程計算系統的下一個狀態是什麼,如此一來即使沒有用公式解開一個微分方程,你還是能夠緩慢的計算系統的演化。」

「我當年有試著這麼做過幾次,不過最終如果沒有數學公式,要怎麼有乾淨漂亮的理解?」我感覺他已經快失去耐心了。

「一來現在我們有機器可以非常迅速地幫你做這些計算,讓你很快地看到系統過了一段時間後會是什麼樣的狀態。二來這就像是做實驗一樣,只不過這次我們能夠擁有實驗中所有的細節,如此一來便有機會在這些中間的複雜計算細節之上,建立一些中間層次的抽象理解。」

「聽起來有點有趣。」大概率這只是牛頓不失禮貌的客套話。「不過我想我的粉絲們好像很想跟我拍照,請容許我暫時告辭。」

經過博士班多年開各種學術會議的訓練,我已經很習慣大佬們的反應了。在實際做出什麼些東西之前,說再多都是一樣。這其實也是科學吸引我的地方,好的表達和包裝固然重要,大家最終還是看真本事。

對於英國歷史的無知,讓我在西敏寺剩餘的時間主要著重在膚淺地欣賞雕刻與建築,看到大文豪還有音樂家時,我也只能混入群眾偷偷多拍幾張照片,心裡偷偷羨慕英國能有這樣一個地方保存和展現自己國家的文化與歷史。

踏出西敏寺時,太陽依然熱烈,往來的人潮更多了。一旁的大笨鐘是這麼的耀眼,讓我的腳步不知不覺被吸引了過去。看著遊客們開心地拍照,幾個孩子興奮地跳來跳去,我的心情也忍不住跟著雀躍著。能在這個時節來拜訪倫敦真是不錯呀,沿著泰晤士河漫步時,我默默地想著,就像能在這個年頭做個跨領域的電腦科學家也真是幸運呀。

03 Sep 2023

(See here for an English version)

大英博物館身為全世界第一間讓任何人都可以參觀的博物館,同時也背負著許多歷史的包袱,諸多館藏的來歷大多擺脫不了當時大英帝國的殖民與侵略。而有趣的是,博物館大門正對面的美食小巷中,過半數的餐館都在賣異國料理(尤其亞洲食物居多),其中一家專賣英國著名小吃Fish and Chip的小店,竟然還是韓國人開的!

前幾個月前才和家人逛了一天的紐約大都會博物館,於是在翻開大英博物館的地圖時,乍看之下還以為是複製貼上。尤其是在逛完埃及區之後,除了眾多的無名氏木乃伊(和貓咪木乃伊)和羅賽塔石碑之外,對見識淺薄的我來說沒有感到太令人驚艷之處。古埃及文化三千年的歷史畢竟沒那麼容易被全盤抄家,這些世界知名的博物館們頂多也只能專攻某些王朝。每次踏出展區時,先不論時空錯亂的荒謬感,我總是感到十分困惑,捉摸不清自己到底是站在什麼樣的視角看待這些人類歷史文明的過客。

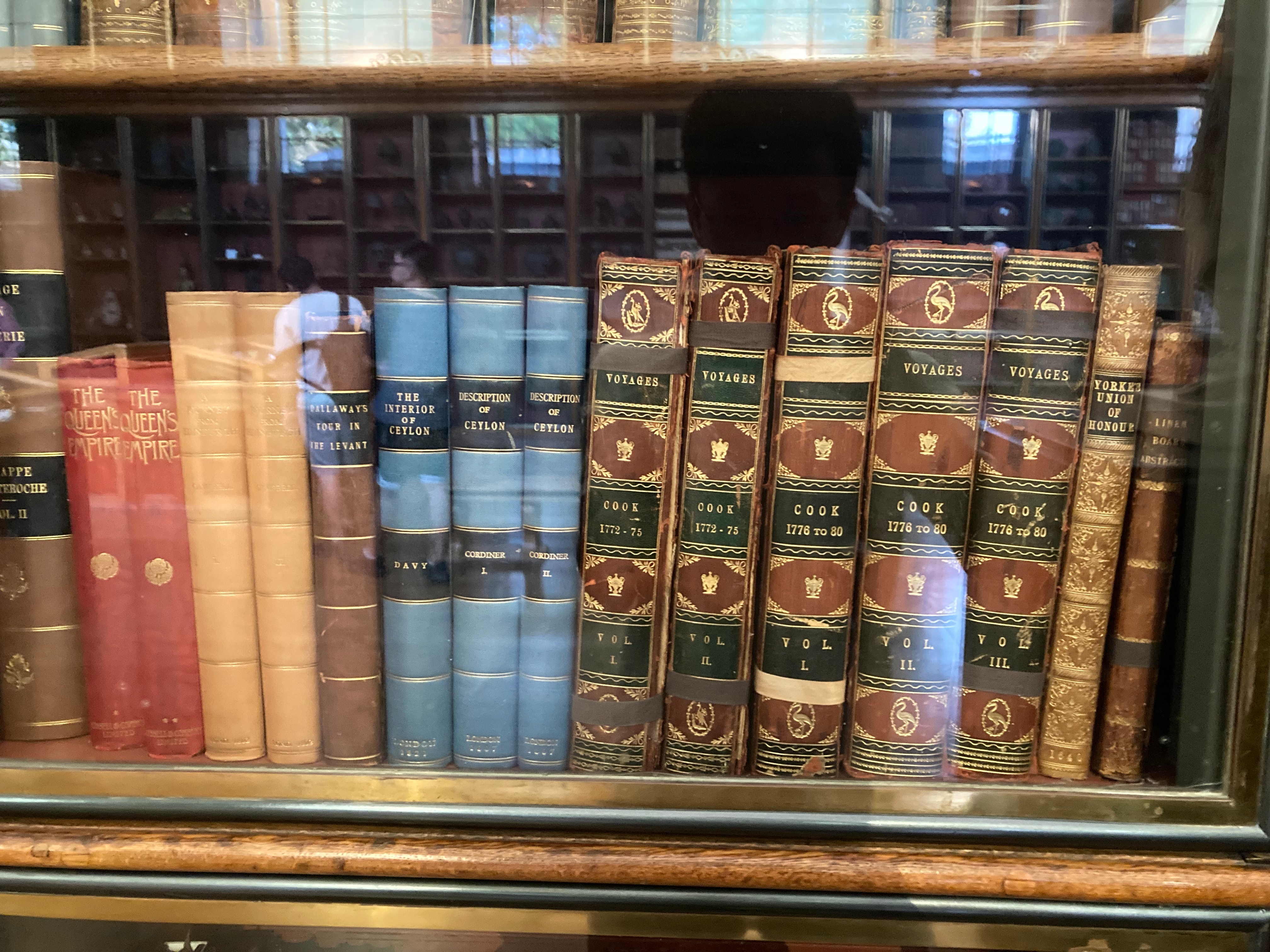

趁著肚子餓之前,我決定晃一下相對比較小的啟蒙時代(The Age of Enlightenment)展區。我仍印象深刻啟蒙時代曾在高中歷史課時折磨我無數次,在大學入學考試錯的那12題中,我蠻確信有一題是關於啟蒙時代的。不過至少我還知道英國在當時扮演著世界的領導者,這次的大英博物館之旅,應該是個好機會讓我重新認識這個在人類近代歷史中重要的時期吧!

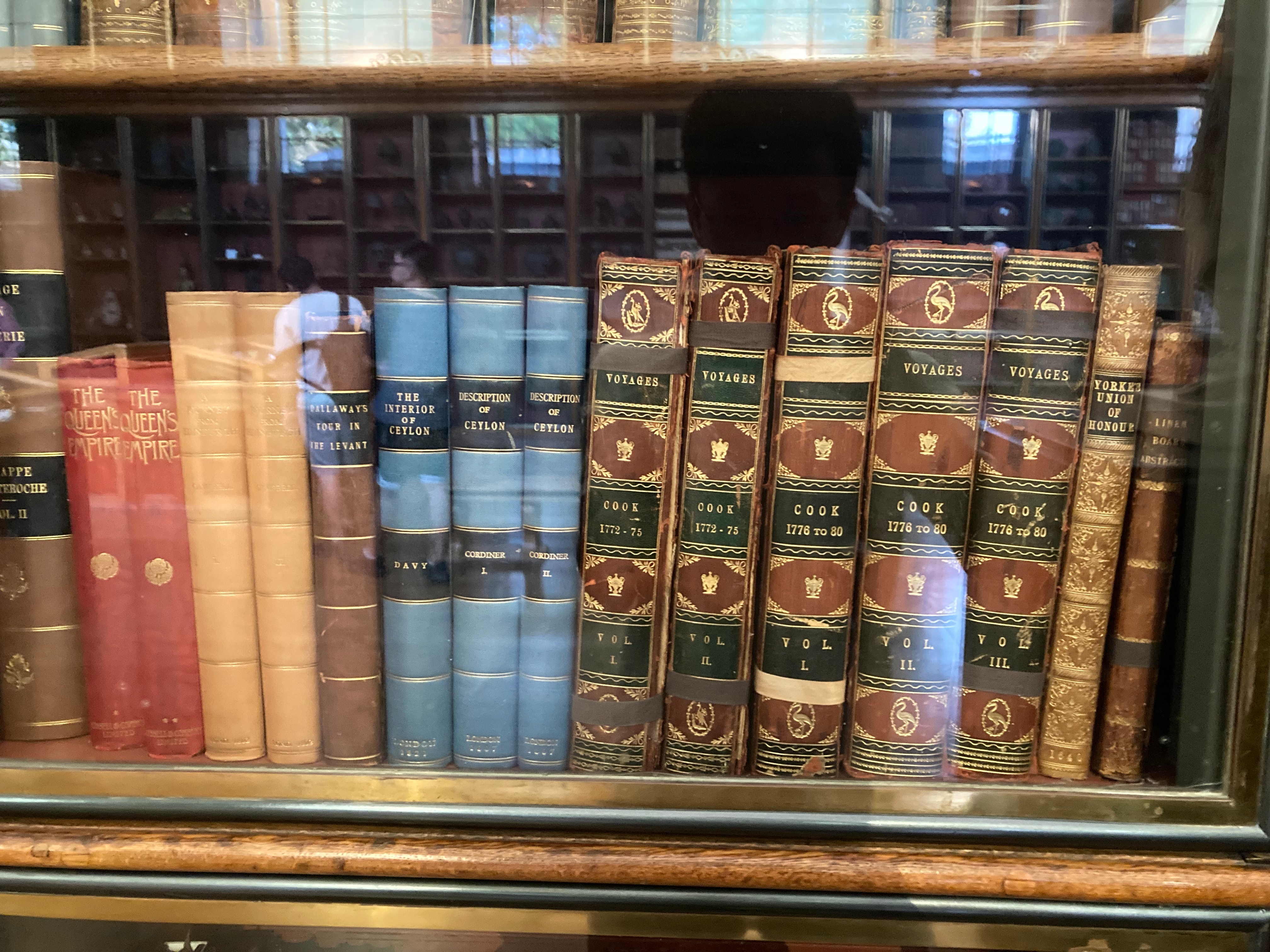

兩側高聳的木頭書架與展示櫃,讓人彷彿置身一座古老的圖書館,稀疏的遊客也讓人終於能選擇自己的腳步。門口的解說牌簡單地介紹到人們是如何在啟蒙時期轉換了整理知識的方法,從中世紀對宗教與神學的重心,漸漸轉移到蒐集、分類與整理的方法論。這樣再尋常不過的解說,過去的我可能讀完之後,走到下一個轉角就忘光了,這一次我的思緒卻被深深吸引住了。緩緩掃過書架上的書名,一方面納悶怎麼可能會有人去讀十本關於某個名不見經傳的小島遊記,一方面驚嘆這些啟蒙時代的人怎麼會有這般毅力與熱情,把各種千奇百怪的主題寫成一本又一本厚厚的磚頭。

I conclude that there is no thing constantly observable in nature, which will not always bring some light with it, and lead us further with the knowledge of her ways of working.

我得出以下的結論,大自然中沒有任何一個能被經常觀察到的事物,是沒辦法不斷地帶來一些關於它們的靈感,並引領我們更進一步認知她運作的方式。

- John Locke

在現代教育體系的嬌寵之下,一直到了讀博士的最後幾年,我才漸漸意識到知識形成的不易,以及許多看似理所當然的事情是多麼不理所當然。直到自己要開始推進人類知識的前沿時,才真切地感受到在一望無際的大海中,選擇往哪個方向航行時的迷茫。

如今在科學當道的世風之下,我們的思考與知識的形成方式是否又再度陷入死胡同?一來我們不再像當年啟蒙時代的人們,有著勇氣和機會在年輕時放下一切環遊世界,記錄所見所聞,蒐集歸納演繹觀察與知識。二來特定的思考模式緊緊地掐住我們的腦袋,總是會下意識地用著習慣的舒服方式進行思辨。面對資訊在質的稀釋與量的暴脹,我們是否需要一場新的啟蒙運動?又或是這場運動已經在不知不覺中悄悄發生了。

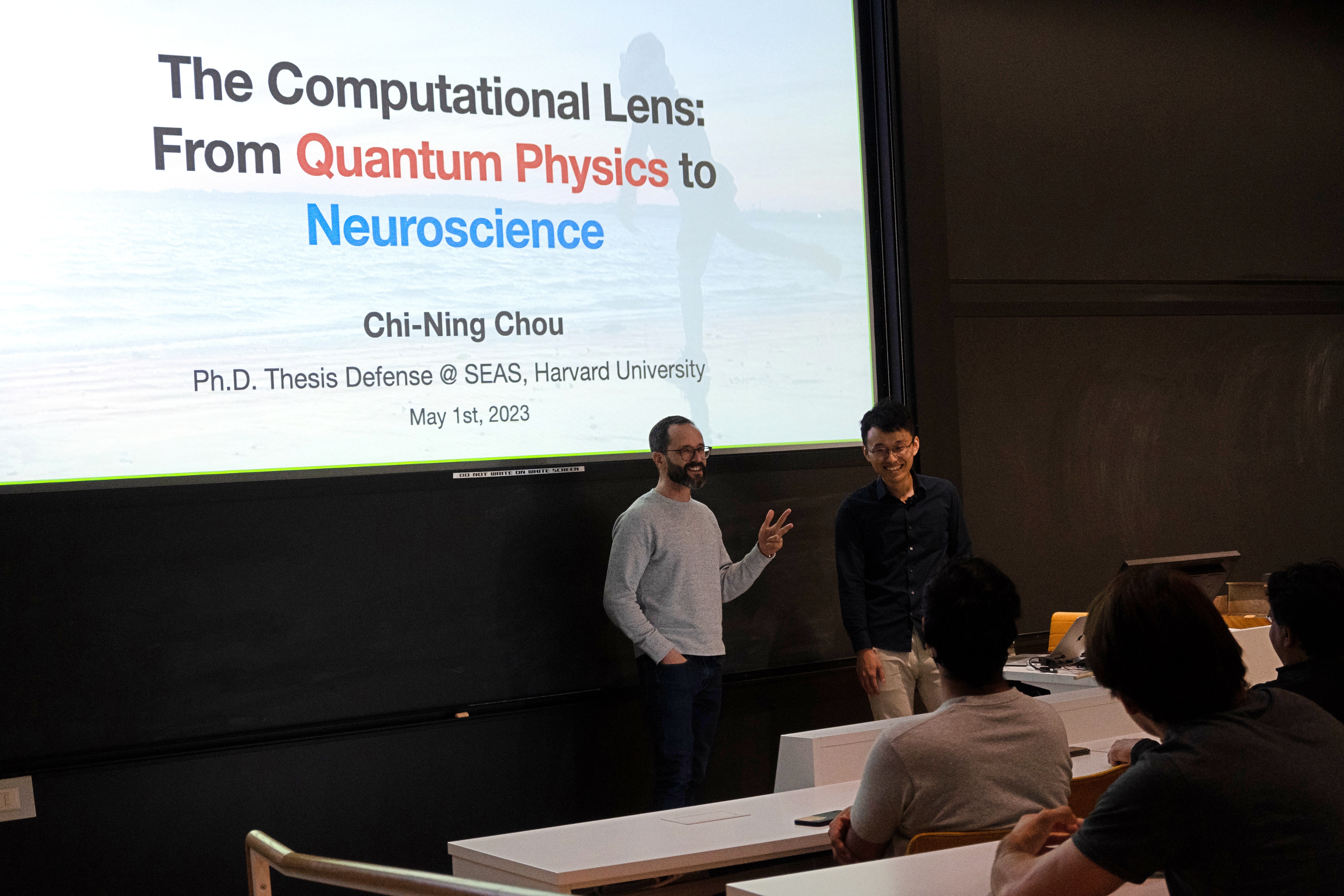

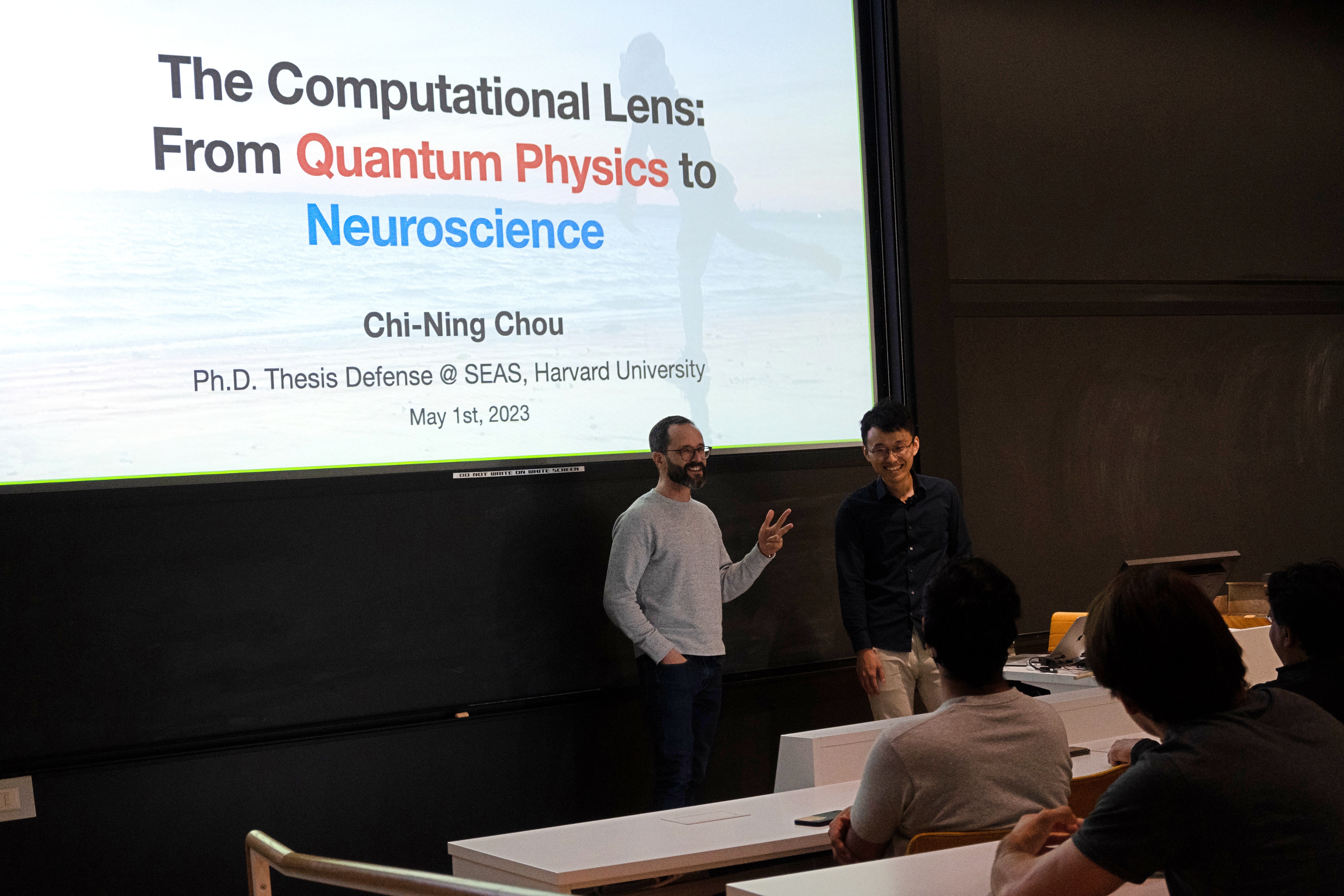

02 May 2023

(See here for an English version)

從五六年前就開始想像的那一天,就這樣眨眼間過去了。現在回想起來許多細節仍歷歷在目:一大早烤箱帶來的香氣和悶熱、邊吃著Bagel邊和室友與拜訪的朋友看著跑跑卡丁車敗部復活賽、開車兇猛的Lyft司機、伏地挺身的痠痛。Ph.D.答辯的這一天就像是場籌備已久的舞台劇,一切幾乎都完美地照著劇本走下去(除了洗完澡後從練琴變成了驚喜派對),順暢到連當時的我都沒機會停下來幾秒,閉上眼感受當下心中的悸動。室友跟我說這一天的感覺,大概就跟結婚日差不多。身邊圍繞著這幾年來對我來說很重要的朋友們,我真是個幸福的人。

讀博士的這六年,當然是充滿著起起伏伏。在演講後招待會中的六道食物分別暗喻了每一年的心境轉變(感謝大學好友承昌一起想名稱):

初惑甜頭Seduced by sweetness(奶酪):第一年的我就像是個進入甜點店的小孩,看到什麼都想要吃上一口,肆無顧忌地吸取著各種養分。

品香嚐鮮Tasting the spices(Mysore pak):第二年有了許多開會和參加workshop的機會,去了西岸、英國、印度(在那邊嚐到了好吃的Mysore pak)和瑞士,見識到不同的研究風格和環境。

焦心力竭Burnt off passion(巴斯克蛋糕):第三年疫情的襲擊間接地讓我開始重新審視自己做的研究,並對理論CS的方法論產生疑問,對手中研究課題的熱情逐漸消磨。

拓邊展界Expanding the boundary(Pizza art):第四年我開始系統性地學習物理和腦神經科學,在研究合作和讀書會中擴展知識的邊界,重新找到對知識追求的熱忱。

揉煉完美Kneading for perfection(Sourdough):第五年我嘗試描繪出未來中長期的研究計畫,完美主義的精神讓我對自己有許多嚴厲的批判,徘徊在不同方法論之間,嘗試找出自己的一條路。

重省初心Rediscovering the roots(蒼蠅頭):第六年時我確定了接下來一步要踏往腦神經科學,同時也漸漸意識到科學方法中必然的不完美,因此漸漸放下對理論CS的批判,重新思考計算能夠扮演的角色。

在傍晚的驚喜派對中,好友L問到我在Ph.D.這幾年有沒有什麼遺憾。當下我很直覺地説,遺憾是一定會有的,就看主觀上我們是如何感受和接納它們。雖然乍聽之下是個故弄玄虛的場面話,但這樣的心態可是近幾年來我慢慢領悟到的道理。我當然很遺憾當年許下的Ph.D.三大目標(拿最佳論文獎、跑波士頓馬拉松、開鋼琴獨奏會)一個都沒有達成,當然很遺憾沒有好好珍惜身邊許多重要的人事物,當然也很遺憾答辯這天錯過了跟好多人講講話、拍照的機會。

但就像棒球教導我的,不管之前被三振了幾次,還是暴傳被教練罵個臭頭。每當站上了球場,過去發生的起起伏伏都是前進的養份,我要讓自己準備好到無論結果如何,都能夠笑著挺胸面對。

時間雖然看似連續地流逝著,但總是讓人在某些時刻能感受到強烈的分野。沈澱了半天後,在雨後前往琴房的途中,依然微涼的晚霞好像看起來不太一樣了。對許多人來說是場再平凡不過的答辯演講,對我來說既是完成了多年的想像,也總結了百轉千折的摸索之路,揭開了人生下一本書的序幕。